ВидеоТекст

ВидеоТекст ВидеоТекст

ВидеоТекст ВидеоТекст

ВидеоТекст

Наши митапы уже посетили

Наши митапы уже посетили

Бизнес-завтрак в бизнес-клубе Атланты

Бизнес-завтрак в бизнес-клубе Атланты

Иерархия метрик как основа data-driven подхода

Иерархия метрик как основа data-driven подхода

Сфокусированная стратегия: прокси-метрики и бизнес-модель

Сфокусированная стратегия: прокси-метрики и бизнес-модель

Автоматизация целевого маркетинга в ритейле х Rubbles

Автоматизация целевого маркетинга в ритейле х Rubbles

Управление заказами х Starfish

Управление заказами х Starfish

ВидеоТекст ВидеоТекст

ВидеоТекст

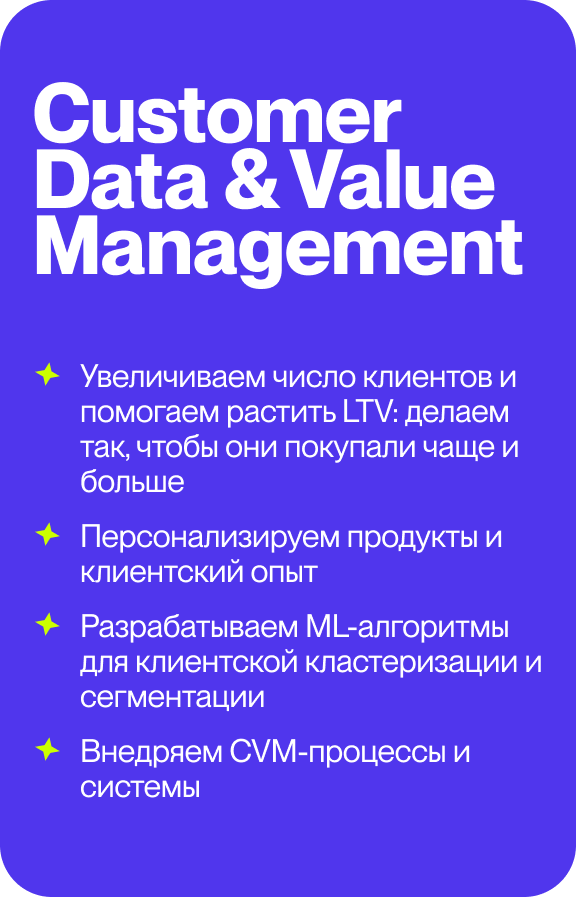

Кейс АЭРО х Кофемания

Кейс АЭРО х Кофемания

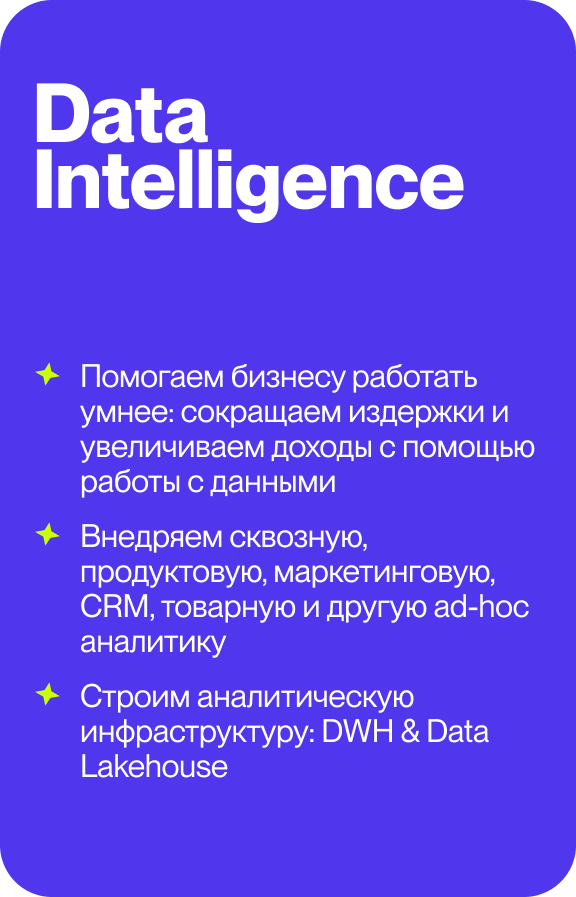

Внедряем корпоративные хранилища данных (или DWH)

Внедряем корпоративные хранилища данных (или DWH)

Кейс АЭРО и Hoff

Кейс АЭРО и Hoff

Анализируем все этапы клиентского пути с помощью инструментов сквозной аналитики

Анализируем все этапы клиентского пути с помощью инструментов сквозной аналитики

ВидеоТекст

Видео

Текст

Для продолжения работы с сайтом, переверните устройство в вертикальное положение.

_preview_blurred.jpg)